От редакции «Скепсиса»: Пять лет назад наш журнал уже публиковал статью Люции Нуриевой и Сергея Киселева, посвященную анализу ЕГЭ. Прошедшие годы показали, что прежние проблемы отнюдь не были «болезнями роста», и ЕГЭ остается непрозрачной, необъективной и по-прежнему уязвимой для коррупции процедурой. Ошибки в заданиях сохраняются, равно как и большое количество заданий-угадаек. Еще более важен тот вывод, к которому приходят авторы исследования: полноценный анализ результатов и недостатков ЕГЭ до сих пор не проводится. Все это заставляет нас, в свою очередь, констатировать: система ЕГЭ не просто плохо продумана и плохо воплощена. Эта система с самого начала была призвана снизить качество образования в стране, слишком образованной для существующего экономического строя. И это, надо признать, ей удалось. Авторы в конце статьи предлагают ряд мер по ее улучшению, но мы сомневаемся как в том, что эти меры в полной мере позволят исправить недостатки ЕГЭ, так и в том, что чиновники от образования пойдут даже на них.

В статье рассматриваются некоторые стороны конкретной практики проведения Единого государственного экзамена, обращается внимание на ряд недостатков в технологии измерений учебных достижений школьников, проверки работ и анализа результатов ЕГЭ[1].

Накануне 2013 года Президент РФ подписал закон «Об образовании», видимо поставившего точку в затянувшихся спорах «быть или не быть» Единому государственному экзамену. С неоднозначными результатами экзамен все же состоялся.

«Настал важный момент, когда должен произойти процесс нормальной “приватизации” результатов ЕГЭ субъектами Российской Федерации, — заявила в одном из интервью руководитель (теперь уже бывший) Рособрнадзора Л. Глебова. — Пришло время задуматься над тем, что делать с результатами с точки зрения анализа итогов госэкзамена»[2].

Действительно, как показывает десятилетний опыт проекта, итоги ЕГЭ нуждаются в критическом осмыслении и инвентаризации. Отсутствие своевременного анализа ведет к консервации застарелых ошибок и запоздалому реагированию на появление новых проблем, что оборачивается против самого экзамена и его участников. В нашей статье мы хотим обратить внимание на конкретную практику проведения испытаний и подведения итогов, недостатки которых могут быть устранены.

Технология измерений

Одним из самых уязвимых мест в тестовой технологии измерений уровня знаний являются закрытые вопросы, позволяющие угадывать ответы. Большую часть работы на ЕГЭ составляют задания закрытого типа с 4 альтернативами выбора (в иностранном языке — с тремя). Их доля в первичном балле по истории и обществознанию составляет почти 40%, по русскому языку, биологии, физике и химии — около 50%. Более того, вопросы с кратким ответом (обычно часть В) в основном тоже закрытые, хотя и предусматривают множественный выбор. Действительно открытых вопросов в контрольно-измерительных материалах (КИМ) по всем предметам очень мало (как правило, только в части С).

Алгоритм выполнения заданий части А — это последовательный просмотр и отсев сомнительных вариантов ответа. Общий недостаток закрытых вопросов — подсказка в альтернативах. Дело даже не в том, что некоторые из них сразу видны как верные. Общим правилом является то, что большинство неверных альтернатив откровенно неправдоподобно. Исключая их, можно получить верный ответ, даже не зная его.

Технология выполнения части А по физике и информатике (где требуются вычисления) максимально приближена к обычной письменной работе. Однако и здесь присутствует элемент подсказки. Закрытый вопрос позволяет сравнивать полученный ответ с предложенными вариантами. Если совпадений нет, то задача решается до достижения успеха. Открытый вопрос сигнала для повторного поиска верного ответа уже не давал бы. При затруднении подходящий вариант выбирается приблизительно. И в любом случае сохраняется 25% вероятность угадать ответ, наобум поставив крестик.

Неплохим инструментом для изучения влияния закрытых вопросов на результаты ЕГЭ является схема Бернулли, позволяющая рассчитывать вероятность получения определенного результата в серии независимых испытаний. В нашем случае мы имеем серию из n заданий части А, в каждом из них есть 4 альтернативы ответа. Угадывание наступает с вероятностью 0,25 (при трех альтернативах — 0,33) и ошибка с вероятностью 0,75 (0,66).

В соответствии с формулой Бернулли

Рn(k) = Ckn pk qn-k, k=0,1,…n

где Рn(k) есть вероятность того, что в n испытаниях произойдет ровно k успехов, определяем, с какой вероятностью можно получить определенное число баллов путем угадывания в серии из n испытаний при начислении 1 балла за верный ответ. Процент вероятности получения определенного результата путем гадания приведен в таблице 1.

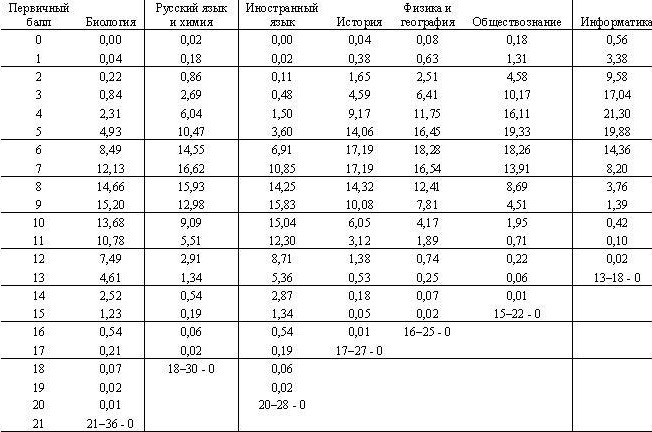

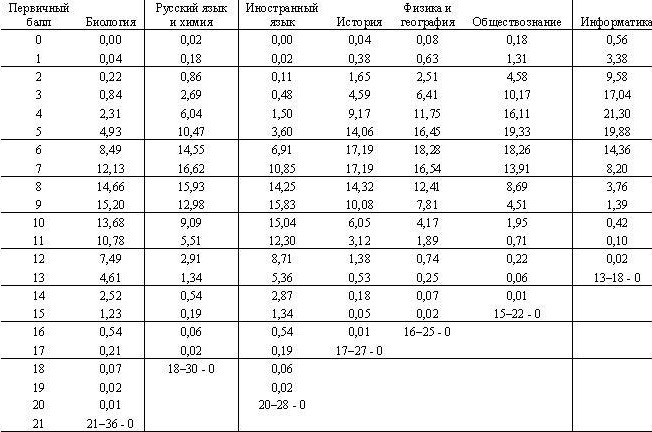

Таблица 1.

Распределение вероятности получения первичных баллов[3] за выполнение части А путем гадания ответов

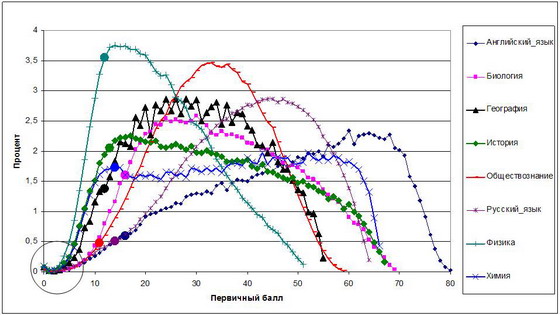

Проиллюстрируем таблицу 1 графиком, который показывает как по мере увеличения в работе числа закрытых вопросов от наименьшего (информатика) к наибольшему (биология) растут шансы учащихся получить баллы (рис. 1). Результаты по иностранным языкам несколько отличаются из-за того, что вопросы здесь закрыты тремя альтернативами.

Рис. 1. Распределение вероятностей получения первичного балла по дисциплинам в случае выполнения работы путем гадания ответов

|

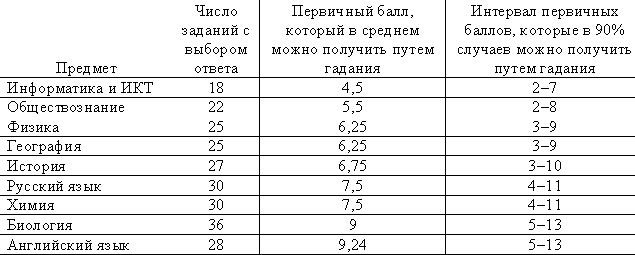

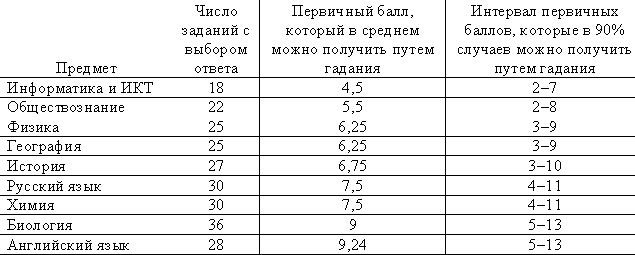

Соответственно таблица результативности выполнения заданий части А путем гадания будет выглядеть следующим образом:

Таблица 2.

Подсчеты по схеме Бернулли показывают, что ноль баллов на ЕГЭ получить почти невозможно. Для этого нужно сдать работу пустой. И действительно, школьники по всем предметам ноль баллов получают чаще, чем один-три балла. Происходит это, потому что они сдают пустые работы.

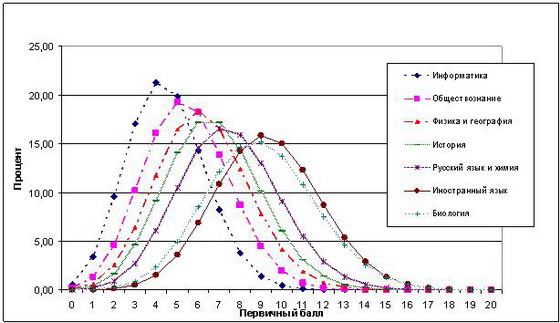

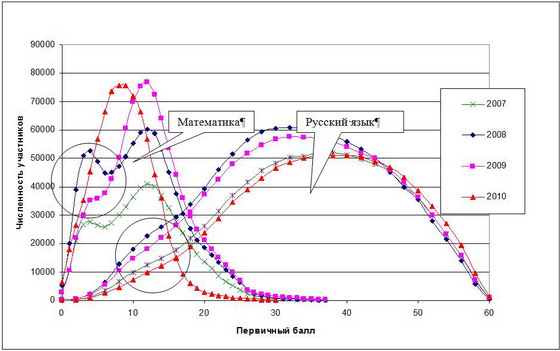

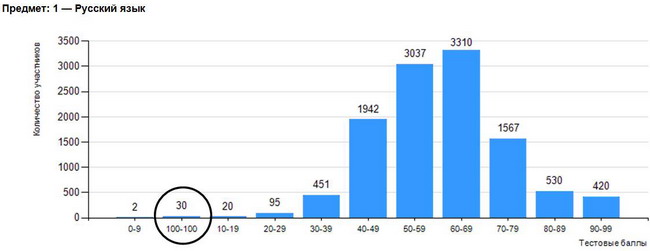

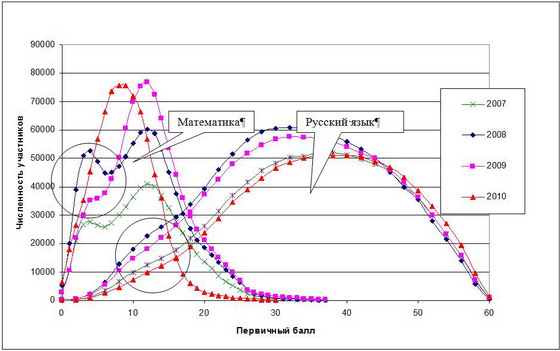

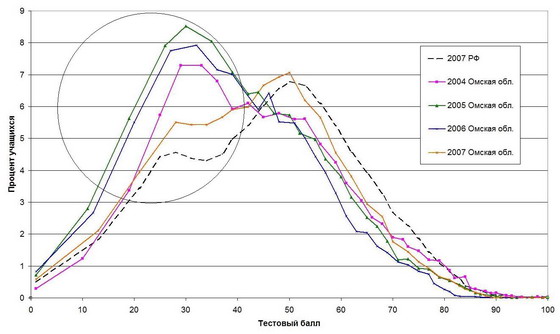

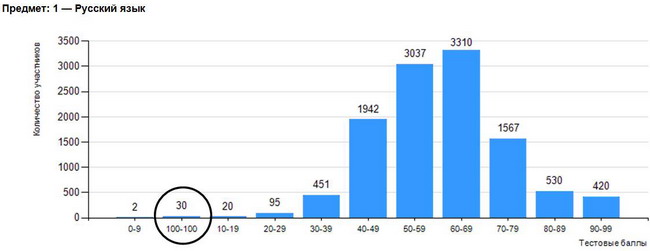

Следы закрытых вопросов в виде «горбов» в начале шкалы хорошо видны в распределении учащихся по баллам на обязательных экзаменах. Наиболее ярко это проявилось в период, когда охват испытаниями стал почти 100% и действовала норма, позволявшая в любом случае получить удовлетворительную оценку. Зная, что тройка им гарантирована, выпускники наобум проставляли крестики в бланке ответов и сдавали работы. Например, в 2007–2008 годах на ЕГЭ по математике почти каждый пятый школьник страны выполнял задания «методом тыка» (подробнее см. [30]). На графике выбросы значений, соответствующие результативности простого гадания ответов, обведены кружком (рис.2). В ежегодных отчетах Федерального института педагогических измерений (ФИПИ) знания детей, показавших минимальный их уровень, постоянно характеризовались как отрывочные и бессистемные. Хотя какая уж тут система?

Рис. 2. Распределение участников ЕГЭ по первичному баллу по Российской Федерации (математика и русский язык)

|

Столь явное проявление в математике заданий-угадаек, выражающееся в распаде массива участников на две части, объясняется тем, что форма записи ответа (числа, выражения, числовые множества, уравнения) не позволяла выбирать альтернативы методом исключения неправдоподобного. Это стимулировало формальное отношение к выполнению работы: учащиеся стали наобум отмечать варианты ответов. В распределении по русскому языку, КИМы которого почти наполовину состоят из вопросов с альтернативами, содержащих подсказки, подъем линии графика той же природы сдвинут вправо и выражен менее (рис.2).

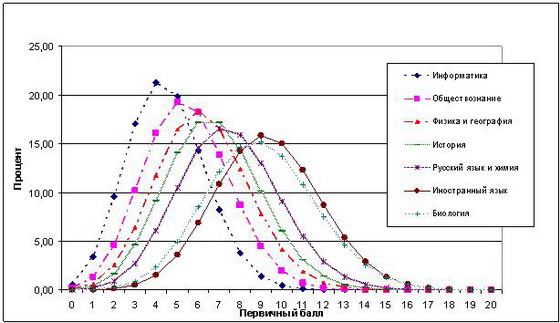

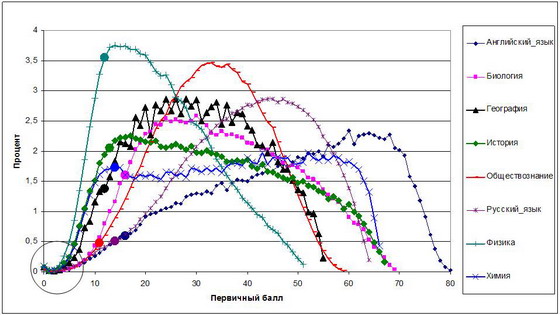

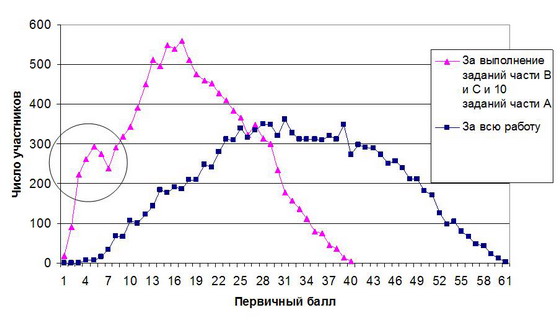

На графиках прочих предметов всплесков, соответствующих результативности гадания, мы не найдем (рис.3). (Впрочем, если заставить выпускников сдавать все экзамены, вопросы-угадайки встанут «горбами» в начале шкалы по всем предметам аналогично тому, как это было в распределении по математике.) На экзаменах по выбору дети стараются максимально хорошо выполнить работу и к гаданию не прибегают. Однако следы вопросов-угадаек мы обнаружим и тут. Обратим внимание, что по всей стране и всем дисциплинам учащихся с 4–5 и менее первичными баллами практически нет. Чем больше в работе закрытых вопросов, тем выше вероятность что-то угадать, тем меньше вероятность получения низких результатов. Как только школьник начинает, даже глядя в потолок, заполнять бланк он непременно проставит верные ответы и что-то «заработает». График распределения по баллам хорошо иллюстрирует этот факт (рис.3).

Рис. 3. Распределение участников ЕГЭ по первичному баллу в процентах по Российской Федерации (2011 год)

|

Понимание того, что знания выпускников проверяются с помощью закрытых вопросов, в значительной мере определяющих результаты испытаний, позволяет избежать ошибок толкования последних. Так, например, уровень, обозначенный Рособрнадзором как минимальный, в значительной мере достигается элементарным гаданием ответов. Поэтому при интерпретации итогов ЕГЭ точку отсчета результативности учащихся следует считать не с нуля, а от значения, когда вероятность получить высокие баллы, наобум отмечая варианты, становится допустимо малой (менее 1%). Для русского языка, например, она составляет 14 баллов, что хорошо согласуется с границей минимального уровня усвоения курса, которую ежегодно устанавливает Рособрнадзор — 17 баллов (2013г.). Для английского языка эти показатели насчитывают 16 баллов по формуле Бернулли (16 — Рособрнадзор), биологии — 17 (16), географии — 12 (14), истории — 13 (13), обществознания — 14 (15), физики — 12 (12), химии — 14 (14). (На графике соответствующие точки обозначены маркером). Данный факт свидетельствует, насколько невысоки федеральные требования к подготовке учащихся. Ведь работу нужно выполнить немногим лучше, чем с известной долей везения наугад проставлять крестики в бланке ответов.

Проблема вопросов-угадаек уже поднималась во время работы Комиссии по совершенствованию ЕГЭ, созданной при Президенте РФ. В декабре 2010 года на встрече с президентом министр образования заверил, что его ведомство неоднократно проводило исследования, доказывающие невозможность сдать ЕГЭ путем угадывания. Более того, из КИМов по математике закрытые вопросы вообще исключены. Все это действительно так. Обратим, однако, внимание на одну деталь: убраны закрытые вопросы из контрольно-измерительных материалов дисциплины, где они были представлены менее всего[4]. В 2009 году (до смены формата экзамена) их доля в первичном балле за всю работу составляла лишь 27% (для сравнения: в русском языке, биологии, физике, химии их около 50%). На наш взгляд, часть А из КИМов по математике удалена не столько потому, что ее легко заменить открытыми вопросами с ответами в виде целого числа или десятичной дроби, хорошо читаемых машиной (ведь в физике и информатике часть А осталась), сколько потому, что распределение результатов наглядно и «предательски» показывало, как велико влияние закрытых вопросов на общий результат.

Казалось бы, стоит ли обращать внимание на такую мелочь, как возможность школьника что-то угадать? Таким путем высоких результатов на экзамене никогда не получить. К тому же все равно все участники ЕГЭ находятся в одинаковых условиях.

Посмотрим, тем не менее, к чему такое допущение приводит на практике. Сравнение достижений учащихся производится не по первичным, а по тестовым баллам, система начисления которых равных условий уже не создает. Шкалы перевода предусматривают начисление максимальных тестовых баллов минимальным и максимальным первичным. В результате участники, проставляющие на экзамене кресты «от фонаря», тестовыми баллами МАКСИМАЛЬНО НАГРАЖДАЮТСЯ. Но это полбеды. Учащиеся, делающие лишь единичные ошибки, потерей тестовых баллов МАКСИМАЛЬНО НАКАЗЫВАЮТСЯ.

Например, за работу наугад на экзамене по русскому языку «непредвзятая диагностика ЕГЭ» одарит лоботряса 7–8 первичными или 15–17 тестовыми баллами. Сильных школьников, потерявших 7–8 первичных баллов из 80 возможных (10%), она обворует на пятую часть тестовых (20%). Отсюда понятной становится уже почти закономерная картина: неожиданно высокие результаты у детей, учившихся в школе на «3–4», и относительно низкие показатели у отличников, призеров олимпиад и различных конкурсов по предметам. Именно нелепая система оценивания позволяет обвинять школы в «липовых» медалистах, а олимпиады и конкурсы — в слабых победителях. Собственно в этом кривом зеркале ЕГЭ и отражается состояние школьной подготовки.

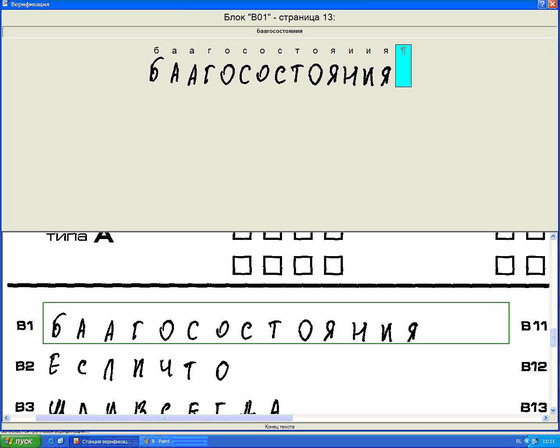

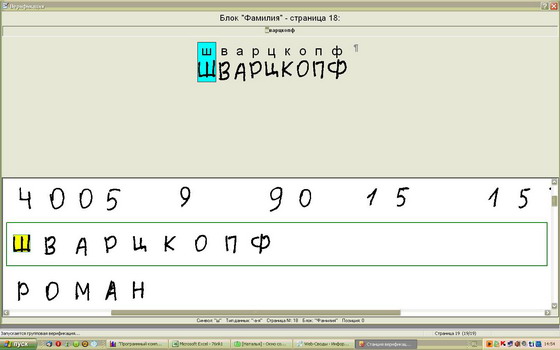

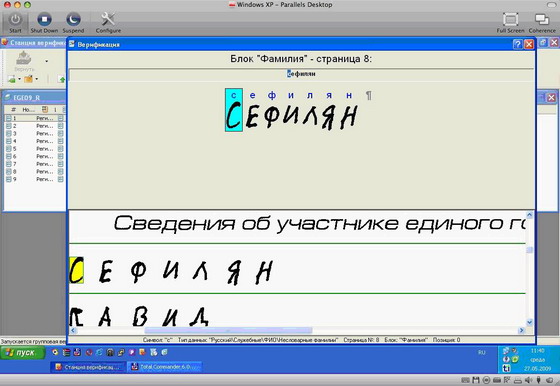

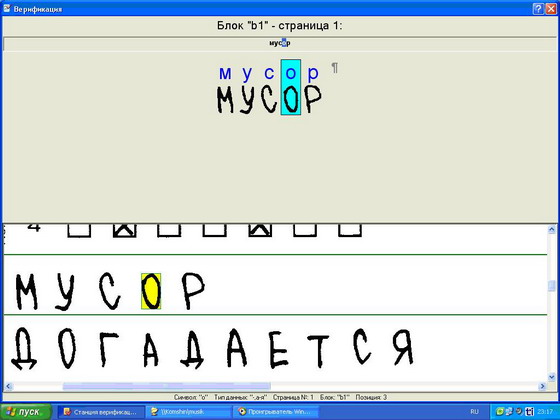

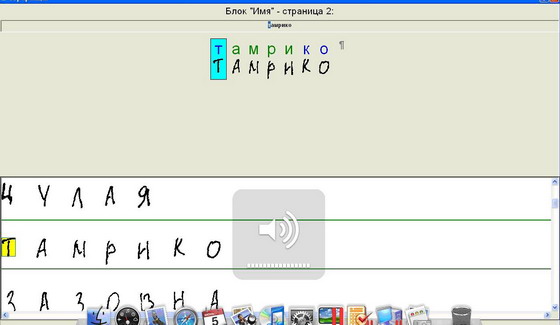

Отказ от закрытых вопросов и линейная шкала перевода баллов сделают систему оценивания более корректной. Основной причиной сохранения закрытых вопросов является технологичность их обработки. Между тем открытые вопросы тоже легко и быстро обрабатываются. Следует лишь изменить технологию: перейти от проверки символов, которыми записан ответ, к проверке его смысла. В действующей практике каждый бланк ответов верификаторы до рези в глазах, «до буквы», сравнивают с текстом, полученным при машинном распознавании. Таким способом открытые вопросы действительно проверяются очень трудно.

На наш взгляд следует поступать иначе. Необходимо перевести результаты распознавания задания (пусть это будет, скажем, В1) в массив и отсортировать его по алфавиту (или по той или иной степени сходства). Поскольку ответы представляют собой однотипные записи с вариациями, вызванными ошибками распознавания, сходные ответы тут же сгруппируются. В группах сразу будут видны отклонения в орфографии отдельных записей, не влияющие на их смысл. Ошибки исправляются приведением ответов к единой для группы форме одним щелчком мыши[5]. И так с каждой группой. После этого массив будет представлять собой несколько групп грамматически верных и одинаковых записей, соответствующих смыслу, который вкладывал школьник. Ответы, не попавшие в группы, будут единичны. Их легко просмотреть обычным способом. Аналогично далее проверяется задание В2 и т.д. Такая проверка может быть сделана очень быстро и качественно[6]. Осталось лишь соотнести полученные варианты с верным ответом.

Применение архаичной системы проверки работ является причиной многих «болячек» экзамена. Так, например, удаление из контрольно-измерительных материалов по математике заданий в закрытой форме без адекватных изменений в технологии верификации повлекло обеднение содержательной части проверяемых элементов базового уровня. В угоду технологичности обработки результатов (ответ должен быть записан числом, легко читаемым машиной) были принесены в жертву такие вопросы курса алгебры и начала анализа средней школы базового уровня как множество значений функции, графики основных элементарных функций, правила дифференцирования и таблица производных. Не проверяется теперь на базовом уровне и такой блок раздела «Уравнения и неравенства» как задачи на нахождение множества решений неравенств (дробно-линейного, показательного, логарифмического, иррационального). Задание В12 в некоторых вариантах только на первый взгляд требует решения неравенства. На самом деле в этих задачах достаточно найти корни соответствующего уравнения. В итоге умение решать неравенства (и их системы) проверяются только в заданиях повышенного (С3) или высокого (С5) уровня. По этой же причине не проверяются и умения решать тригонометрические уравнения. Более того, ограничения на форму записи ответа (целое число или конечная десятичная дробь) содержит обычную для закрытых вопросов подсказку в случае, если в результате вычислений, например, получается рациональное число ⅓, которое нельзя представить в виде конечной десятичной дроби.

Наглядный пример влияния формы записи ответа на результат представляет собой задание типа: «Найдите наименьшее значение функции y=(x2–7x+7)ex–5 на отрезке[4,6]». Очевидно, что только при х=5 можно получить ответ, который не содержит числа е, а значит и решать эту задачу нет смысла, благодаря ограничениям на запись ответа.

Технология проверки работ

Проблемы оценки уровня знаний выпускников не ограничиваются недостатками технологии измерений. Серьезные изъяны имеют также инструментарий проверки и ее организация.

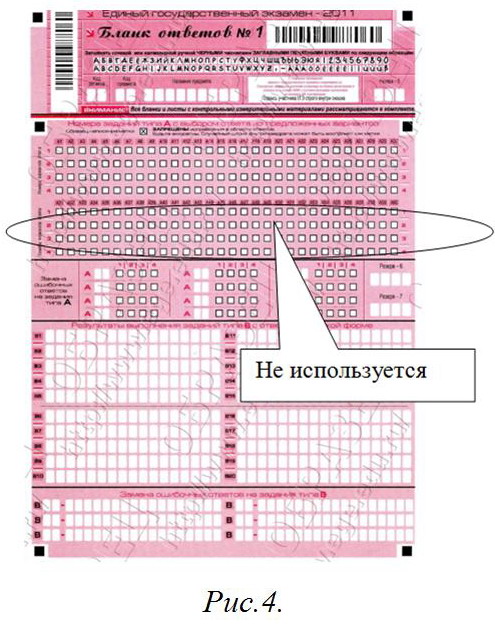

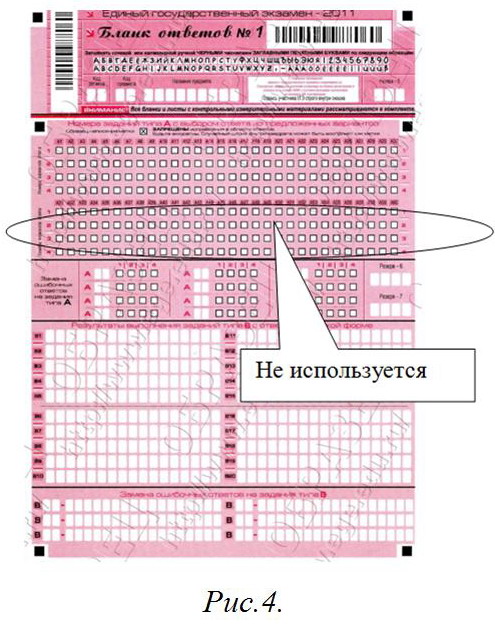

За все время проведения ЕГЭ повышенное внимание организаторов уделялось качеству контрольно-измерительных материалов. И это правильно. Однако, абстрагируясь от их содержания, заметим, что сами КИМы баллов не начисляют. Баллы начисляются по бланкам ответов, содержимое которых знаний учащихся может не отражать. Связано это со сложностью заполнения бланков, оплошностями школьников при проставлении ответов, ошибками и низкой дисциплиной верификации.

Начнем с того, что бланк ответов, единый для всех предметов, в части А рассчитан аж на 60 вопросов (рис.4). От вплотную налепленных ячеек рябит в глазах. Между тем в КИМах всех дисциплин часть А насчитывает не более 30 заданий (кроме биологии, где их 36). Таким образом, второй блок клеток бланка почти не используется. За все 10 лет существования экзамена более трети ячеек для ответов части А не использовались никогда! А второй блок клеток задействовался лишь в 5–6% случаев (такова доля человеко-экзаменов по биологии).

В 2011 году среди восьми сотен омских учащихся, чей результат по русскому языку составил свыше 80 тестовых баллов (Это лучшие ученики, составляющие лишь 6% всех участников), в среднем за часть С потеряно 2 первичных балла из 23 возможных (или 8%), за часть В — 1 из 11 (или 9%). Зато за часть А потеряно 6 первичных баллов из 30 (или 20%). В сложных заданиях части В и С у сильных школьников ошибок вдвое меньше, чем в куче простейших угадаек. Объяснение этому может быть одно: ошибки в части А у хорошо подготовленных выпускников связаны в основном с банальной путаницей в постановке крестиков в «частоколе» клеток заданий, не представляющих в действительности для этой группы экзаменуемых практически никакой трудности (апелляция, кстати, здесь не предусмотрена). В этих условиях большую роль при ранжировании участников по высоким баллам играют уже не столько собственно знания (а уровень подготовки таких учащихся понятен), сколько иные факторы: скрупулезность в заполнении клеточек (теперь мы проверяем и такие характеристики выпускников) и качество распознавания и верификации ответов.

В иностранных языках закрытые вопросы вообще имеют только три альтернативы. Здесь бланк ответов не соответствует КИМам. Любой верификатор подтвердит, что школьники вместо третьего (последнего в КИМах) проставляют четвертый (последний в бланке) вариант. Это автоматически означает ошибку. Приведем замечательный фрагмент отчета ФИПИ по английскому языку:

«…количество ошибок при переносе ответов в бланки (запись лишних слов или символов, ошибки в выборе позиции ответа, приводящие к полному отсутствию ответов в бланке ответов по какому-либо заданию) (выделено нами. — Авт.), продолжает увеличиваться, что свидетельствует о снижении общей функциональной грамотности экзаменуемых, а также о том, что при подготовке к экзамену уделяется недостаточное внимание ознакомлению учащихся с бланком ответов и правилам работы с ним» ([12,с. 5].

Может ФИПИ стоит просто почистить бланк от мусора, разрядить клетки и привести его в соответствие КИМам?

На протяжении почти всех 10 лет проведения ЕГЭ верификация ответов осложнялась конструкцией КИМов. Закрытые вопросы, где ответ состоял из набора букв, проверялись с большим трудом. При распознавании текста машиной заглавная буква «А» путается с буквой «Д» и наоборот, «И» с буквой «Ч», «Н», «К» и т.д. Если школьник пишет прописью (а значительная часть участников экзамена игнорирует требование писать заглавными печатными буквами), то машина путает буквы «б», «в», «д». Даже верификатор иной раз затрудняется сразу определить, какую букву проставил школьник. Нередки случаи, когда вместо номера альтернативы учащийся пишет ее текст.

Рис. 5. Верификация задания В6

|

На рисунке 5 приведен процесс верификации задания, где школьник должен записать ответ символами кириллицы[7]. Здесь изображена чрезвычайно распространенная ошибка, когда вместе с кодом альтернативы пишется ее порядковый номер. В нашем примере для записи ответа использовались цифра 3 и буква «З». Внешне они неразличимы. Верификатор должен оставить только допустимые символы, поэтому 3 и «З» останутся. Верный ответ будет верифицирован как ошибочный. И это хорошо, если в условиях жесточайшего аврала оператор станет досконально разбираться во всех таких записях.

Между тем проблема решалась элементарно. Обозначения альтернатив следовало бы сразу сделать цифровыми. По свидетельству ФИПИ, замена в 2011 году в вопросе В5 по обществознанию буквенного обозначения вариантов ответа на цифровое дало 20% рост его решаемости[10,с.7][11,с.8]. Иными словами, низкий показатель был вызван не слабыми знаниями учащихся, а ошибками верификации.

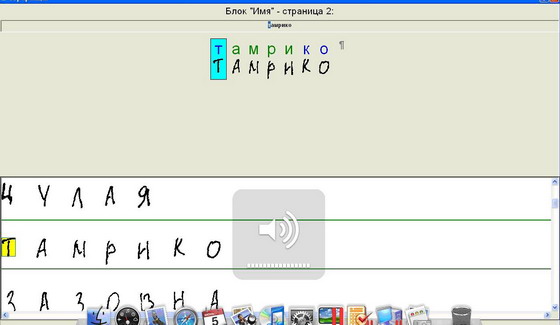

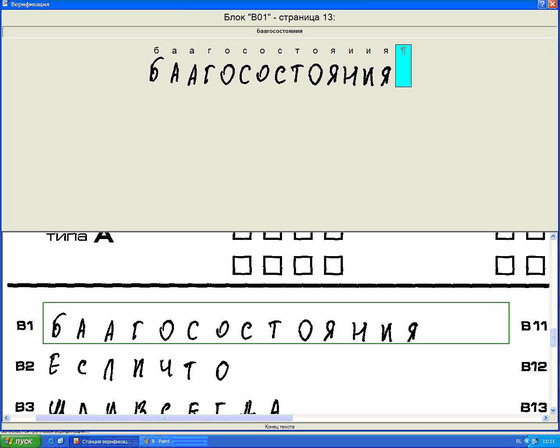

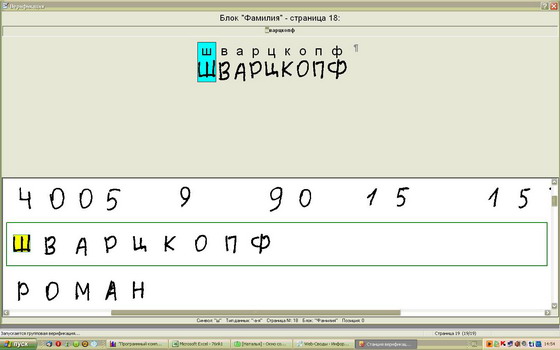

Сама программа верификации «TestReader» также нуждается в совершенствовании. Нацеленная на распознавание каждого знака, она составляет бессмысленные наборы символов из вполне читаемых слов. На рис. 6 приведен пример верификации слова «Благосостояния», где «TestReader» составил слоги, в русском языке не встречающиеся («БААГ» и «ЯИИЯ»)[8]. Между тем не следует делать упор на точности распознавания каждой буквы. Требуется правильно распознавать слоги. Процесс значительно ускорится, если программа сама будет подбирать в слоги наиболее вероятные сочетания букв, ибо практически вся верификация состоит из исправлений такой простейшей несуразицы.

Рис. 6. Окно верификации

|

Сомнительным представляется и использование единой для всех предметов системы распознавания. Действительно, программа «TestReader» позволяет работать с различным материалом (символы латиницы, кириллицы и цифры) и отличает один знак от другого. Но понять ответ целиком она не в состоянии. К тому же ответы состоят не только из слов. У каждой науки своя знаковая система: латинские и греческие буквы, математические символы, химические и физические формулы и т.д. Программы верификации должны «понимать» с каким материалом они имеют дело, в чем «TestReader», увы, абсолютно «не разбирается». Поэтому распознавать записи, представленные в виде формул, на ЕГЭ за десять лет так и не научились.

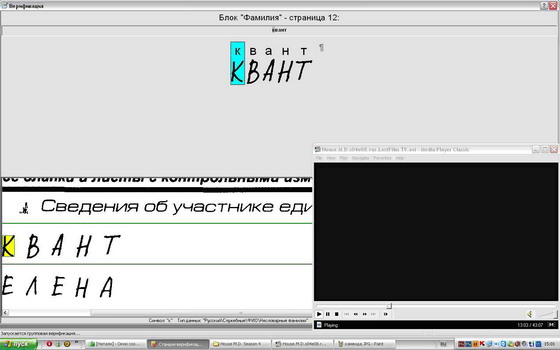

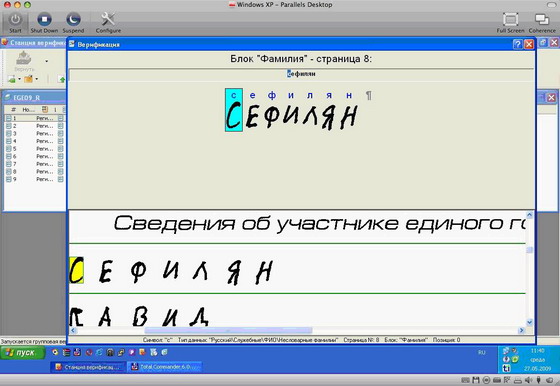

Технологию проверки работ невозможно рассматривать также вне контекста ее организационных вопросов. Острой проблемой экзамена остается дисциплина участников, прежде всего школьников. О недоработках организаторов если сообщается, то очень немного (см.[22, с. 16; 18, с. 11–12]). Между тем если взглянуть на работу региональных центров обработки информации (РЦОИ), можно обнаружить интересные вещи.

Одному из авторов статьи (С.К.) «посчастливилось» в течение двух лет работать в Омском региональном информационно-аналитическом центре системы образования (РИАЦ), выполняющего функции РЦОИ, участвовать в двух кампаниях по верификации школьных работ (в 2010 и 2011 годах), наблюдать организацию проведения ЕГЭ изнутри. Что-то из увиденного является общими проблемами всех РЦОИ, что-то можно отнести к местной специфике[9].

Главной особенностью функционирования РЦОИ является сезонный характер занятости. Работа здесь имеется только в период проведения испытаний (середина мая — июль), т.е. 3 месяца в году[10]. Во время массовой обработки экзаменационных материалов (июнь) нагрузка становится запредельно высокой. Бланки ответов следует пропустить через сканер и программу распознавания и установить соответствие их содержания символам, распознанным машиной. Установление такого соответствия осуществляется вручную операторами станций верификации. Несмотря на кажущуюся простоту, верификация является довольно трудной работой. В течение трех-четырех недель без выходных, по 8–10 часов не отрываясь от экрана, операторам необходимо сверять каракули школьников с текстом, который распознала машина. Своих сотрудников для этого в РЦОИ, как правило, недостаточно, поэтому они могут привлекать дополнительных работников по договору. На оплату верификации в регионы специально направляются деньги.

Недостаток людей для верификации РЦОИ на местах, видимо, восполняют по-разному. В Омском РИАЦ, например, «под ружье» ставят всех: не только программистов, методистов, аналитиков, но и бухгалтеров, секретаря, рабочих типографии (в Омске учителя школьные работы больше не проверяют). Наиболее стойкие сотрудники в дополнение к дневным сменам работают и по ночам: т.е. где-то 14–16 часов в сутки. Отказ от привлечения людей со стороны объясняется стремлением освоить присылаемые Москвой деньги узким кругом штатных сотрудников или «своих» людей. Верификация превращается в «калым».

Введение Государственной итоговой аттестации (ГИА) усложнило задачу своевременной проверки работ. Вместо того чтобы привлекать людей со стороны на определенное время, Министерство образования Омской области пошло на увеличение штатов РИАЦ. В нем был создан отдел из шести человек, основной задачей которого стал сбор статистики по сфере образования (ранее этот функционал между делом выполнял всего один сотрудник). Обеспечив верификацию операторами, министерство усугубило проблему занятости. Основным времяпрепровождением новых работников в межэкзаменационный период стали пустые посиделки, блуждания в интернете, компьютерные игры и просмотр видеофильмов. К слову сказать, Омский РИАЦ собрал на своем сервере огромную видеотеку, изучению которой и стали посвящаться усилия нового отдела[11]. Падение дисциплины отразилось и на верификации. Приведем несколько скриншотов из «коллекции», собранной работниками РИАЦ (рис.7). Одновременно работающие программы отображаются на линейке внизу, из чего следует, что вместе с верификацией специалисты центра заняты еще массой нескучных дел: читают книги, переписываются по электронной почте и смотрят кино,

слушают музыку (здесь оператор настраивает громкость):

работают с программами Excel, МОРФ, Парус,

собирают скриншоты. Факт того, что последние сделаны с разных станций, позволяет делать выводы о распространенности таких нарушений.

Все это, разумеется, качеству проверки работ ничуть не вредит. Не мешает даже просмотр сериалов: например, «Доктор Хаус», 4 сезон, 8 серия. Надо полагать, что предыдущие 70(!) серий этот верификатор уже посмотрел[12]. Сколько работ он за это время «проверил» остается только догадываться. Кто-то точно подметил, что проблемы ЕГЭ — это проблемы менталитета. Хотим добавить, что менталитета не только школьников.

Рис.7. Скриншоты из «собрания» РИАЦ

|

Бывший руководитель Рособрнадзора В. Болотов, как-то посетовав на низкую дисциплину экзамена, предложил для ее поддержания привлекать армию. Что касается Омской области, то старшину впору ставить в кабинетах, где проверяются работы учащихся[13].

Насколько сказываются на качестве верификации недостатки ее организации, вероятно, не скажет никто. Однако согласно статистическим исследованиям, проведенным по заказу Министерства образования и науки РФ группой специалистов Московского института открытого образования под руководством И.Ященко, в 2011 году до 7% участников экзамена получили оценку, которая не соответствует их знаниям[14]. В этот показатель вошли все погрешности измерений, в том числе ошибки верификации.

Анализ результатов

Одним из главных недостатков организации экзамена в настоящее время является система подведения итогов, а именно отсутствие их должного анализа. Материалы, посвященные «разбору полетов» в субъектах Федерации, как правило, строятся по схеме, применяемой ФИПИ: характеристика контрольно-измерительных материалов и контингента участников, сведения о выполнении различного рода задач, выводы и рекомендации по совершенствованию преподавания предмета. Солидные по объему они почти одинаковы по содержанию. Значительную часть в них занимает пересказ нормативных документов. Из года в год они повторяют одни и те же выводы и рекомендации. Более того справки ФИПИ, например, местами дословно переписаны из отчетов прошлых лет. В строгом смысле некоторые работы трудно назвать аналитическими, т.к. носят они преимущественно описательный характер. Большая часть содержащейся в них информации может быть представлена в табличной форме. Литературные дарования составителей в ряде случаев украшают эти документы, но не спасают положения. В них практически нет объяснений причин успехов и неудач школьников. Однако даже эта работа сопровождается систематическими ошибками и упущениями. Укажем на ряд из них на примере материалов ФИПИ, а также работ Московской, Мурманской, Новосибирской, Омской и Томской областей[15].

Рассмотрим сначала ошибки интерпретации результатов ЕГЭ.

1. Подведение итогов без учета особенностей состава участников и условий проведения испытаний. Довольно часто аналитики делают выводы о тенденциях в изменении уровня подготовки выпускников в отчетном году путем простого сопоставления результатов с прошлогодним уровнем. Без учета особенностей состава участников и условий проведения испытаний делать это нельзя.

К сожалению, одними из первых такой пример нам показывают специалисты ФИПИ. В 2006 году они приходят к заключению о повышении уровня математической подготовки выпускников по сравнению с предшествующим годом[1,с. 41], проигнорировав при этом увеличение доли участников из крупных городов[1,с. 16], где по признанию самого ФИПИ показатели всегда были выше.

Омские аналитики, определяя равнотрудность заданий, принялись вычислять разницу между средним процентом выполнения «простого» и «сложного» вариантов, делая выводы о неравнозначности КИМов. Однако, как выяснилось, так называемые «простые» варианты были распространенны среди более подготовленных городских школьников, а «сложные» — среди сравнительно слабых сельских[26, с. 31]. Равнотрудность заданий и вариантов высчитывалась и в других регионах[22, с. 31–33, 90]. Однако есть подозрения, что эти сравнения проводились без учета особенностей состава участников, т.к. местные специалисты данную проблему не поднимали вовсе.

Длительное время распространенной ошибкой было невнимание к условиям проведения экзамена, напрямую определяющим его результаты. В 2004–2008 гг. происходило массовое подключение к ЕГЭ новых регионов. Обязательность экзамена вела к расширению состава участников за счет нежелающих его сдавать. Чтобы побороть сопротивление эксперименту на местах Рособрнадзор установил правило «+1», гарантирующее выпускникам получение удовлетворительной отметки при неудовлетворительном результате. Но это стимулировало не участие в испытаниях, а его имитацию. На экзамене школьники стали наобум рисовать крестики в бланке ответов и сдавать работы. И такая форма «выполнения» заданий становилась все популярнее.

Размеры саботажа обязательных экзаменов в те годы поражают. Например, в 2007–2008 годах доля школьников, выполняющих задания по математике наугад, составляла до 20% по стране. Поражает и другое — близорукость специалистов, этот саботаж не замечающих. Более того, ФИПИ в своих отчетах преднамеренно замалчивал проблему, пряча неприятные факты в обтекаемых выражениях:

«При интерпретации результатов ЕГЭ следует иметь в виду, что значительный процент учащихся, показавших неудовлетворительный или невысокий уровни подготовки, частично объясняется отсутствием положительной мотивации на овладение курсом математики у слабо подготовленных выпускников, которым известно заранее, что при любом даже неудовлетворительном выполнении работы им обеспечена хотя бы минимальная положительная аттестационная отметка “3” или они не планируют поступать в вузы, где надо сдавать математику»[3,с. 20].

«Холодным душем» для омского руководства образованием стали, например, результаты экзамена по математике в 2005 году. Область оказалась в пятерке худших регионов страны[16]. Все чувствовали, что здесь что-то не так, но объяснить произошедшее не могли. Омский аналитический центр только сводил статистику и разводил руками. Между тем основной причиной низких результатов была бездумная политика руководителей разного уровня. С их подачи среди школьников широко развернулась агитация «за ЕГЭ»: «Дети! Не волнуйтесь. Меньше тройки вы не получите». Дети и не волновались…

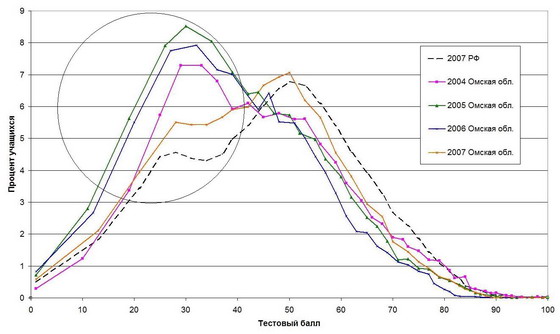

Чтобы оценить масштабы халтуры приведем распределение учащихся по тестовому баллу в период с 2004 по 2007 год (рис.8), которое свидетельствует, что в первые три года участия Омской области в ЕГЭ на экзамене по математике просто «от фонаря» проставили крестики свыше трети выпускников — 34% (в 2007г. — 26%)! (Значения, соответствующие результативности гадания обведены кружком.) Обескуражено фиксируя низкие показатели, ни Омский аналитический центр, ни местное министерство образования об этом даже не догадывались, и по итогам ЕГЭ региональные руководители отрасли из года в год беспомощно краснели перед губернатором.

Рис. 8. Распределение омских учащихся по тестовому баллу (математика)

|

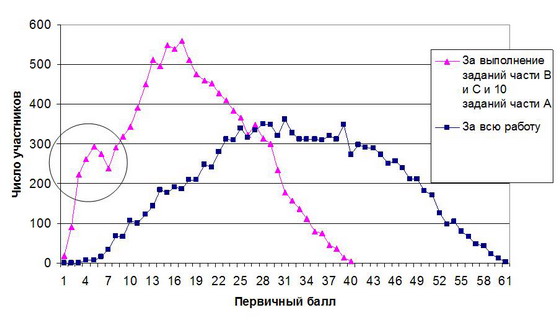

Следы бойкота ЕГЭ мы найдем и в результатах по русскому языку. Они проявляются в виде левостороннего подъема линии графика распределения по баллам, особенно хорошо заметного в 2008 году (т.е. до отмены правила «+1») (рис.2). Масштабы саботажа здесь тоже поддаются оценке. Для этого воспользуемся следующим приемом: при подсчете первичного балла уменьшим число вопросов части А до 10, как это было в математике[17]. Таким образом мы получили, например, графики распределения омских выпускников по первичным баллам за всю работу (нормальное распределение) и по сумме баллов за части В и С и любых 10 заданий части А (бимодальное распределение). Второй из них свидетельствует, что в 2008 году около 15% омских учащихся, не мудрствуя, отмечали варианты ответов наобум (рис.9). Аналогичные результаты, правда, в несколько меньших размерах обнаружились и при исследовании результатов 2009 года. В 2010–2011 годах из-за отмены правила «+1» саботаж ЕГЭ по русскому языку в омских школах сошел на нет.

Рис. 9. Распределение омских учащихся (11 тыс. чел) по первичному баллу в 2008 году (русский язык)

|

Игнорировали условия проведения испытаний не только в Омске. Исследователи из Мурманска в 2008 году наблюдали резкий спад результатов по математике, объясняя его ухудшением подготовки[18], в 2009 году — столь же резкий подъем, вызванный ее улучшением[19]. Чем были вызваны эти колебания, объяснить они не смогли.

Аналитики Московской области в 2008 году приводят таблицу зависимости тестового балла от количества часов в неделю изучения математики, из которой следует, что разница в успехах учащихся обучающихся 4 часа (гуманитарный класс), 5 часов (общеобразовательный класс) и 6 часов (профильный класс) невелика. Далее следует вывод:

«Это говорит как о примерном равенстве контингента учащихся разных классов, так и о том, что многие учителя при большем числе учебных часов не столько расширяют и углубляют знания учащихся, сколько решают большее число однотипных заданий. Однако отработка навыков не дает должного эффекта».

О том, что расширение состава участников, правило «+1» и обязательность экзамена стимулировали его саботаж специалисты, видимо, не подозревают. А ведь именно последний вел к нивелировке тестового балла у изучаемых групп[13, с. 28].

В 2009 году в поисках причин общих успехов специалисты Московской области последовательно перебирают и сравнивают с прошлогодними результаты выполнения отдельных заданий. Не найдя существенных изменений в редакции КИМов, они делают выводы об улучшении уровня подготовки, верно заметив при этом, что рост показателей произошел в заданиях с выбором ответа[14, с. 20–23]. Задания с кратким ответом остались в минусе. Поэтому последовало следующее заключение: «Так как содержание заданий ЕГЭ–2009 не претерпело существенных изменений по сравнению с прошлым годом, трудно оценить прогресс или регресс знаний учащихся по всей школьной программе»[14, с. 24]. Проигнорировав изменения условий испытаний, исследователи зашли в тупик. Отмена гарантированной тройки снизила формальное участие школьников и гадание в части А, вызвав рост ее решаемости. По части В результаты, наоборот, ухудшились, т.к. гадать там было невозможно. Поэтому вывод по Московской области должен быть другим: в 2009 году работа выполнена хуже, чем в 2008-м.

На эти же грабли наступают в Новосибирске. Здесь так объясняют повышенные результаты в 2009 году:

«В то же время существенное увеличение среднего балла по математике (на 22%) является следствием интенсификации процесса подготовки выпускников к ЕГЭ. При этом важно понимать, что в этот процесс включаются не только школьные учителя, но и подготовительные курсы вузов, репетиторы и пр. Немаловажную роль в получении такого прироста в величине среднего балла сыграли и штатный режим экзамена, и принятие педагогической общественностью его обязательности»[18, с. 18–19].

О том, что из-за отмены правила «+1» школьники просто перестали гадать, аналитикам в голову не пришло. Далее они по той же причине делают еще один неверный вывод, объясняя повышение коэффициента корреляции результатов ЕГЭ и школьных оценок в 2009 году возросшей адекватностью оценивания учителем предметных достижений обучающихся[18, с. 30].

Ошибки в оценке ситуации на местах отчасти лежат на совести ФИПИ, ибо бойкот экзамена он замалчивал. Графики 2004–2009 гг., опубликованные в отчетах института, содержат несложную уловку. Они выполнены в виде гистограмм, где значения, соответствующие угадыванию ответов, спрятаны в суммах интервалов шкалы и не бросаются в глаза, а потому не комментируются. В 2009 году повышение результата по математике ФИПИ, например, объясняет усиленной подготовкой, скрывая факт формального участия школьников на ЕГЭ–2008:

«Наблюдаемая тенденция некоторого повышения уровня математической подготовки выпускников средней школы в 2009 году обусловлена в значительной степени тем, что они были мотивированы на продуктивную подготовку к выпускному экзамену в связи с отменой правила “+1” при оценке выполнения вариантов КИМ»[4, с. 69].

2. Сопоставление средних баллов по дисциплинам с общероссийскими показателями. Пожалуй, самой распространенной ошибкой являются сравнения региональных результатов с общероссийскими. Такие сопоставления с учетом ряда оговорок можно делать только по обязательным предметам. В дисциплинах по выбору необходимо обращать внимание на контингент участников, т.к. он может не отражать действительной структуры школьников всей страны. Например, состав учащихся, сдающих французский язык, наполовину представлен выпускниками Москвы, Московской области и Санкт-Петербурга, которые в значительной мере и формируют этот якобы «общероссийский» балл. Сравнение тут идет не со «среднероссийским», а со «среднестоличным» уровнем. И имеет ли смысл высчитывать региональный балл, если участников экзамена можно пересчитать по пальцам?

При сравнении баллов по обязательным предметам необходимо также учитывать особенности социального развития каждой местности, в частности их урбанизацию, поскольку в регионах с повышенной долей городского населения показатели всегда будут выше. Видимо, межрегиональные сопоставления корректны среди территорий со сходными социально-экономическими условиями функционирования образовательных учреждений: например, на уровне федеральных округов, результаты которых ФИПИ, к сожалению, не публикует[20].

3. Сопоставление среднего балла по дисциплинам. Простыми и наглядными, казалось бы, выглядят сравнения средних баллов по разным дисциплинам. Сами собой напрашиваются выводы о том, по какому предмету школьники лучше учатся. Так составители одного из отчетов пишут:

«Представляется, что в целом по сравнению с результатами, продемонстрированными при сдаче других экзаменов, результаты по обществознанию выглядят достаточно неплохо, если учесть, что для данного экзамена был установлен наиболее высокий минимальный балл»[22, с. 186].

Между тем представляется некорректным сравнивать средние баллы по разным дисциплинам. На итоги экзамена самым непосредственным образом влияют содержание, количество, характер и сложность заданий, которые при межпредметных сопоставлениях невозможно соотнести. Тот факт, что средний балл по русскому языку составил 57, а по математике 44, вовсе не означает, что русский язык школьники лучше знают. Один только формат КИМов, где превалируют задания, позволяющие угадывать ответы (русский язык), дает ощутимую фору его участникам перед школьниками, вынужденными давать краткий ответ (математика). В экзаменах по выбору к тому же имеются значительные отличия в составе участников, поэтому средний балл показывает уровень только их подготовки.

О том, что межпредметные сопоставления баллов некорректны, соглашаются и специалисты ФИПИ:

«…на результаты ЕГЭ могут влиять различные факторы: состав участников, особенности КИМ, организационные особенности проведения экзамена и др. В этой связи нельзя однозначно сравнивать результаты по разным предметам, даже тестовые баллы, полученные по обязательным предметам и предметам по выбору»[4,с. 11].

Ошибки содержательного анализа результатов испытаний

1. Аналитики не обращают внимания на тот факт, что под одинаковыми кодами содержатся задания разных типов[27][22, с. 192]. Широко распространенной ошибкой в течение первых пяти лет проведения экзамена было представление о том, что КИМы имеют одинаковую структуру. На самом деле первоначально КИМы создавались на основе нескольких планов, являвшихся модификацией общего плана, обозначенного спецификацией. Под одним кодом в разных вариантах скрывались задания разных типов[21]. То, что такое возможно, организаторы не афишировали. Но после того как на местах стали сводить несводимое в спецификациях с 2007 года стали появляться предупреждения: «Порядок следования заданий в КИМ может быть изменен в разных вариантах». По мере накопления банка заданий составители стали отказываться от практики перестановки заданий внутри работы. По крайней мере, к 2010 году предупреждающее извещение осталось только в спецификациях по обществознанию, химии и информатике. К 2012 году оно сохранилось только в обществознании. Трудно сказать, насколько эта мера оказалась действенной в предотвращении списывания или обмена результатами во время испытаний. Однако она изначально ставила жирный крест на попытках содержательного анализа ЕГЭ на местах. Без приведения вариантов к единому порядку следования заданий статистика по типам задач представляла собой настоящую «кашу». Именно эту «кашу» и выкладывали РЦОИ в свои статистические сборники (так, в частности, было в Омске). Приводя статистику выполнения заданий, аналитики порой диву даются разбросу их решаемости[15, с. 7–8][22, с. 32, 192], в то время как необходимо было посмотреть на тексты самих заданий.

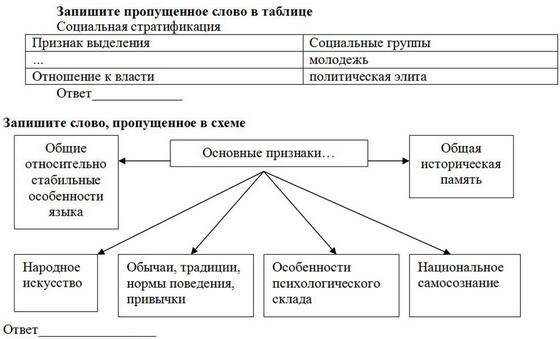

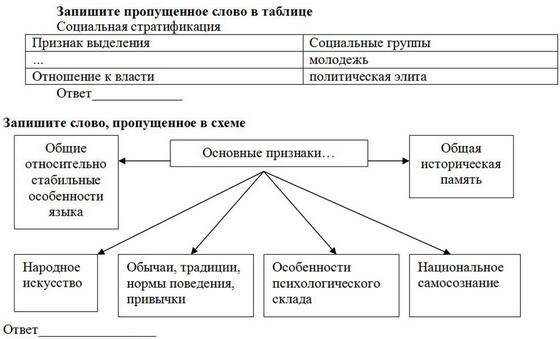

2. Аналитики не учитывают, что содержание или конструкция заданий иногда не соответствует спецификации[13, с. 49][15, с. 48][22, с. 191]. Хорошим примером этой ошибки является задание В1 по обществознанию, проверяемый элемент содержания которого обозначен следующим образом: «Различное содержание в разных вариантах: выявление структурных элементов с помощью схем и таблиц». Здесь, согласно спецификации, процент выполнения демонстрирует уровень умений выявлять структурные элементы с помощью таблиц и схем, но не знаний в какой либо области курса, т.к. эти задания построены на материале из различных его разделов. Задания выглядят следующим образом[23].

Совершенно очевидно, что если знать решение, то записать его не составляет труда. Вот что действительно определяет успешность этой работы так это форма записи ответа. Отсутствие готовых альтернатив и элементов подсказки, присущих закрытым вопросам, ведет к снижению результата. Именно открытый характер вопроса (несмотря на то, что он относится к базовому уровню сложности) приводит к самым низким показателям. Так в 2010 году в целом по стране с этим заданием справились только 51,2% участников. Лишь с частью С и заданиями В5 и В6, представляющими собой вопросы с выбором множественных альтернатив, школьники справляются хуже[5, с. 21]. А поскольку успешность выполнения задания В1 определяется его формой было бы ошибкой не только выдавать результат за оценку умения работать с информацией, представленной в различных знаковых системах (схема, таблица), но даже высчитывать среднее значение, ибо построено оно на материале из разных разделов курса. В сопоставлении решаемостью иных заданий средний балл и процент выполнения задания В1 вообще лишены какого-либо содержательного смысла. (Если задание В1 действительно дифференцирует учащихся по умению выявлять структурные элементы с помощью схем и таблиц (ведь это вопрос открытого типа), то что же тогда измеряют все задания части А, напичканные подсказками?) Поэтому ошибочными являются выводы, например, отчета по Московской области:

«Как показывает анализ результатов ЕГЭ по обществознанию — выпускники слабо владеют умениями … анализировать и классифицировать социальную информацию представленную в различных знаковых системах, в том числе статистическую или графическую (напр. тексте, схеме, таблице, диаграмме)… Это особенно наглядно проявилось при выполнении заданий … В1»[15, с. 53].

То, что КИМы иногда могут не соответствовать спецификации, косвенно признают и специалисты ФИПИ:

«Задания, предполагающие умения классифицировать понятия, явления, социальные объекты путем установления соответствия терминов и их определений, понятий и их признаков, выпускники выполнили в этом году менее успешно, чем в предыдущие годы (25–50%). Возможно, это связано, прежде всего, с тем, что задания этого типа были построены на новом содержании (выделено нами. — Авт.), которое оказалось сложным для усвоения (организационно-правовые формы предпринимательства)»[5, с. 18].

Иными словами, классифицировать школьники стали хуже не из-за снижения умений классифицировать, а из-за смены материала классификации. Хотя по спецификации оценивались именно умения.

3. Игнорирование формы вопроса[23, с. 80, 82][22, с. 192]. Как-то неловко говорить банальности о том, что результативность выполнения задания в значительной мере зависит от формы записи ответа. Между тем зачастую без комментариев, беззубо и беспомощно аналитические отчеты, в том числе ФИПИ, фиксируют факты успешного решения задания повышенного уровня в сравнении с базовым. Так, например, ФИПИ в отчете по обществознанию сообщает:

«В отдельных случаях результат выполнения заданий базового уровня с кратким ответом ниже, чем результат выполнения заданий повышенного уровня с выбором ответа (выделено нами. — Авт.). Так, задание В2 второй части работы по теме “Системное строение общества: элементы и подсистемы” (средний процент выполнения 35%) выполнялось правильно почти в два раза реже, чем задание повышенного уровня А3 (средний процент выполнения 58%)»[5, с. 7].

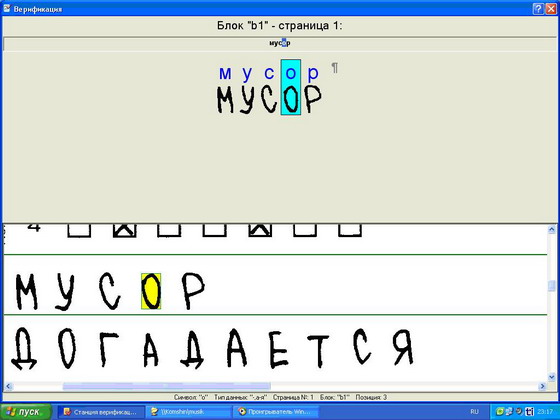

При этом работники ФИПИ не объясняют полученный результат. А ведь причина очень проста. Открытые вопросы всегда представляют наибольшую трудность — они не содержат подсказки.

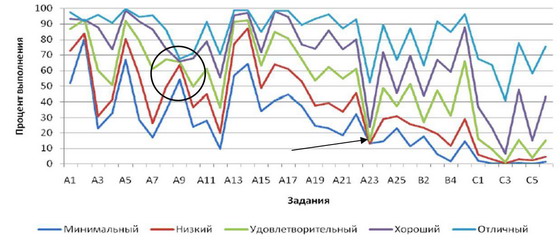

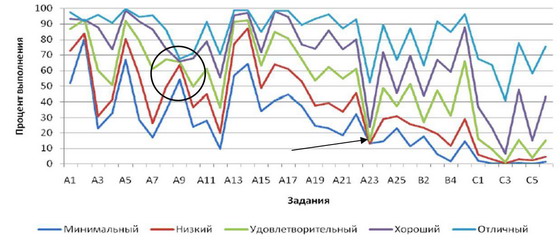

Примеры влияния формы записи ответов на результат можно найти повсюду. В региональных отчетах и справках ФИПИ часто приводятся графики выполнения задач участниками с разной подготовкой. Решаемость заданий части А среди слабых школьников никогда не опускается ниже 10–15%. Теоретически этот показатель должен находиться в районе 25%. На практике альтернативы-провокации снижают его ниже вероятностной отметки. В качестве иллюстрации приведем график ФИПИ по физике (рис. 10), который показывает, что в сравнении с другими заданиями задачу А23 менее всех провалили именно двоечники (задание отмечено стрелкой). Почему? Просто хуже выполнить его уже нельзя: форма записи ответа не позволяет это сделать.

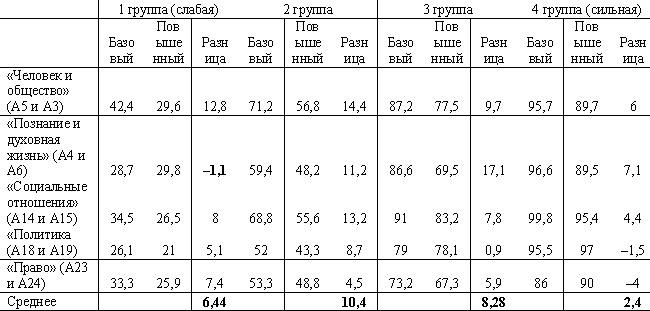

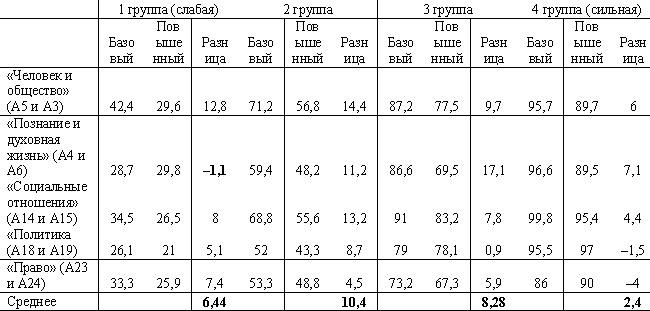

Приведем еще пример. Если сравнивать разницу решаемости заданий базового и повышенного уровня по разделам «Человек и общество» (А5 и А3), «Познание и духовная жизнь» (А4 и А6), «Социальные отношения» (А14 и А15), «Политика» (А18 и А19), «Право» (А23 и А24) в курсе обществознания, то выяснится что минимальные ее значения наблюдаются среди представителей самой слабой и самой сильной группы участников (см. табл. 3). И если в сильной группе это является свидетельством способности справиться с заданиями разной сложности, то в слабой — равной вероятности угадать верный ответ любого вопроса с 4 альтернативами. Только этим можно объяснить тот забавный факт, что по разделу «Познание и духовная жизнь» двоечники «выполнили» задание повышенного уровня сложности (А6) лучше, чем базового (А4)[5, с. 21].

Таблица 3.

Решаемость заданий базового и повышенного уровня по обществознанию (2010 год)

ФИПИ, конечно, понимает, что закрытые ответы угадываются, но признает это уклончиво:

«…требование стандарта можно считать достигнутым…, если 65% и более учащихся… успешно выполнили задание с выбором ответа, проверявшее достижение данного требования. Для заданий с кратким или развернутым ответом установлена граница 50%»[2, с. 22].

Откуда такая разница? Ответ очевиден.

4. Формальный подход к анализу, игнорирование содержания заданий и альтернатив ответов. Главным недостатком аналитических работ является формальный подход к изучению результатов ЕГЭ[24].

В них присутствует какая-то странная уверенность в том, что КИМы подобно деталям из-под штампа хороши и одинаковы, а коды спецификации отражают все их особенности. Между тем это не так.

В КИМах встречаются задания, не имеющие решений. Например, в 2010 году в задании А5 по обществознанию составители не видят разницы между абсолютным числом и процентом (материал за 5 класс). В задании приводится динамика охвата молодежи России программами профессионального образования в процентах, а предложенные альтернативы ответа оперируют понятием «число». Для того чтобы найти верный ответ, школьникам следует не читать предлагаемый график, а засесть за вычисления. При этом знать, как менялась численность населения страны в возрасте от 15 до 34 лет, чего в условии нет.

Встречаются задания, имеющие несколько верных ответов. Так в задании А3 по химии, где специалисты из Томска зафиксировали низкий процент решаемости, в качестве альтернатив было предложено два верных ответа:

«…вопрос о водородной связи: Водородная связь не характерна для

1) H2O 2) CH4 3) HCl 4) CH3OH.

Причиной неудовлетворительных ответов является наличие двух правильных ответов 2) и 3), так как и между молекулами метана и хлороводорода не возникают водородные связи»[22, с. 104].

Встречаются невразумительные задания. Пример приводится в отчете томских коллег. Составители его, фиксируя падение решаемости одного из заданий части С по обществознанию, пишут, что школьникам требовалось

«привести три аргумента в подтверждение авторского вывода о том, что

“демократия является постоянным усилием по созиданию сферы гражданского состояния и обеспечению того, чтобы частные убеждения и групповая принадлежность могли сойтись и соединиться в ней в атмосфере взаимного уважения”.

Отвечающие, как правило, просто не поняли смысла задания, что и определило уровень ответов»[22, с. 198].

Немудрено. Кто же разберет такую галиматью?[25] Интересно, насколько единодушно было бы решение этого задания у самих экспертов? Дифференцирующая способность задания — нулевая.

Встречаются задания с обратной дифференцирующей способностью. Показательной являлась ситуация с задачей А9 по физике на ЕГЭ–2010, обозначенной спецификацией как задание по молекулярно-кинетической теории. По результатам испытаний оказалось, что его одинаково хорошо (плохо) решали как слабые учащиеся, так и отличники, что было вызвано неверным подбором альтернатив. В своем отчете ФИПИ приводит диаграмму решаемости задач учащимися с различным уровнем подготовки (рис. 10)[8, с. 14], но аномальные результаты задания А9 (обведены кружком) обходит молчанием. Между тем школьники с минимальным уровнем подготовки в 20% поступивших в Омск вариантов решили это задание лучше отличников. Таким образом, дифференцирующая способность его — отрицательная. Причина провала — применение альтернатив-провокаций. Составители настолько намудрили с альтернативами ответа, что запутали сильных учащихся. Слабые выпускники, полагаясь лишь на собственный бытовой опыт (речь шла о закипании воды в кастрюле), отмечали самый простой ответ, который и оказался верным.

Рис. 10. График из отчета ФИПИ по физике в 2010 году.

|

О некорректности КИМов сообщают специалисты Санкт-Петербурга, анализировавшие результаты по немецкому языку[17, с. 16], историки Томска[22, с. 145], обществоведы Новосибирска[19, с. 143] и др.

Все это лишний раз подтверждает, что успех решаемости заданий в значительной мере определяется не столько сложностью изучаемого материала, сколько формулировкой вопроса, формой ответа и подбором альтернатив, т.е. качеством инструмента проверки. Результат уже заложен в КИМах альтернативами-провокациями и альтернативами-подсказками. Поэтому обязательным этапом изучения результатов испытаний на местах должен стать анализ используемых в данном регионе контрольно-измерительных материалов.

Не нужно также забывать, что содержание КИМов не всегда соответствует содержанию учебников. В этом признаются сами составители, в частности, по обществознанию. Оказывается «…не все содержательные линии, представленные в ЕГЭ, раскрыты в учебниках с необходимой степенью полноты…»[6, с. 23]. Так ФИПИ осторожно сообщает, что берется проверять материал, которого в учебниках нет[26].

Томские аналитики приводят пример применения задачи С4 по физике,

«связанной с малыми колебаниями одного заряженного тела в поле другого. В критериях предложено решение, в котором используется малая величина второго порядка малости, которой пренебрегают, так как она не вносит существенной поправки в искомую величину. Такие задачи объясняются только в вузе, а в школьной программе ни по математике, ни по физике подобное не проходят. Естественно, что это задание даже никто и не приступал решать»[22, с. 90].

Показательным примером, характеризующим соответствие КИМов школьной программе, может послужить история, произошедшая в 2007 году на пробном экзамене по математике. Оценку в 100 баллов в Омске не получил никто, в том числе абсолютный чемпион Международной математической олимпиады школьников в Ханое[27], выпускник омского лицея № 66 Константин Матвеев. На штатном экзамене максимальный балл получили два омича. Один из них — чемпион мира. Какие измерения ведет ФИПИ?..

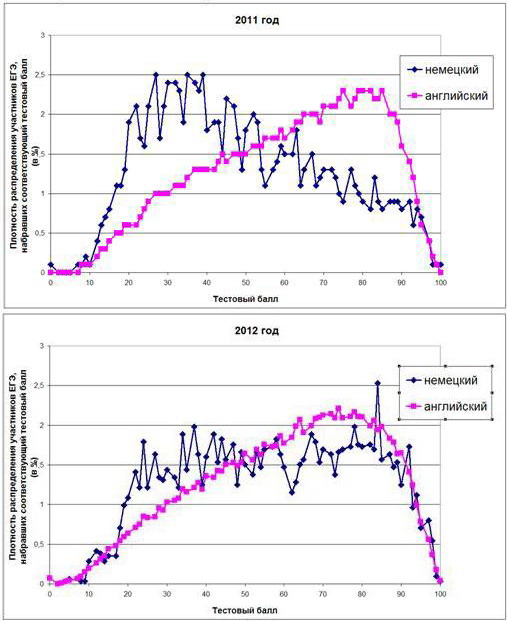

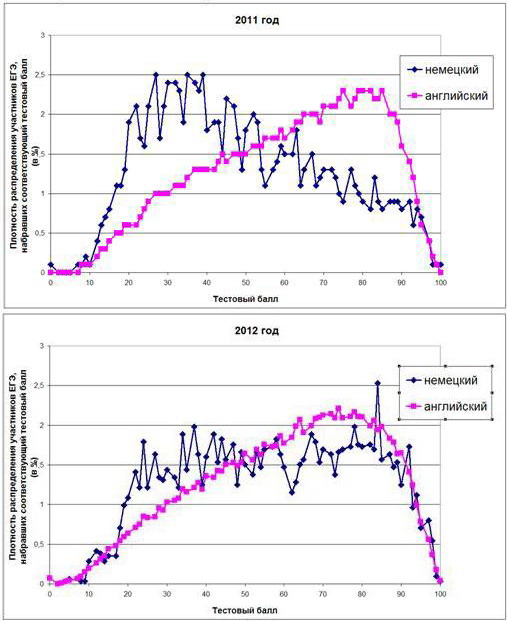

Поверхностный анализ ведет не только к ошибочным выводам, но и не позволяет своевременно корректировать инструмент оценки. Так, например, на протяжении нескольких лет специалисты ФИПИ игнорировали существенные расхождения в результатах испытаний по иностранным языкам. Разница среднего балла по английскому и немецкому языкам в 2008г. составила 8,5, в 2009 г. — 15,1, в 2010 г. — 14, 2011 г. — 10,9. В 2012 году она вдруг резко сократилась до 3,2 баллов. Как получилось, что в 2012 году средний тестовый балл по немецкому языку взлетел на 8 пунктов, а по английскому вырос только на 0,3?

Ответ мы найдем в КИМах. Если посмотреть, где более всего отстают «немцы» от «англичан», то окажется, что это задание В2 базового уровня, перегруженное призовыми баллами (за его выполнение предусмотрено 7 баллов). Именно из-за высоких баллов за выполнение задания В2 и сравнительной легкости его в КИМах по английскому и французскому языкам распределение результатов всегда было смещено вправо (типичный график — 2011 год), чего нет в немецком языке, где задание В2 сложнее (см. рис. 11)[28], так как здесь по свидетельству специалистов из Санкт-Петербурга «тематика экзаменационных текстов и заданий зачастую не соответствует социально-личностному опыту выпускников средней школы»[16, с. 58].

Рис. 11. Распределение учащихся по тестовому баллу

в 2011 и 2012 годах (немецкий и английский языки)

|

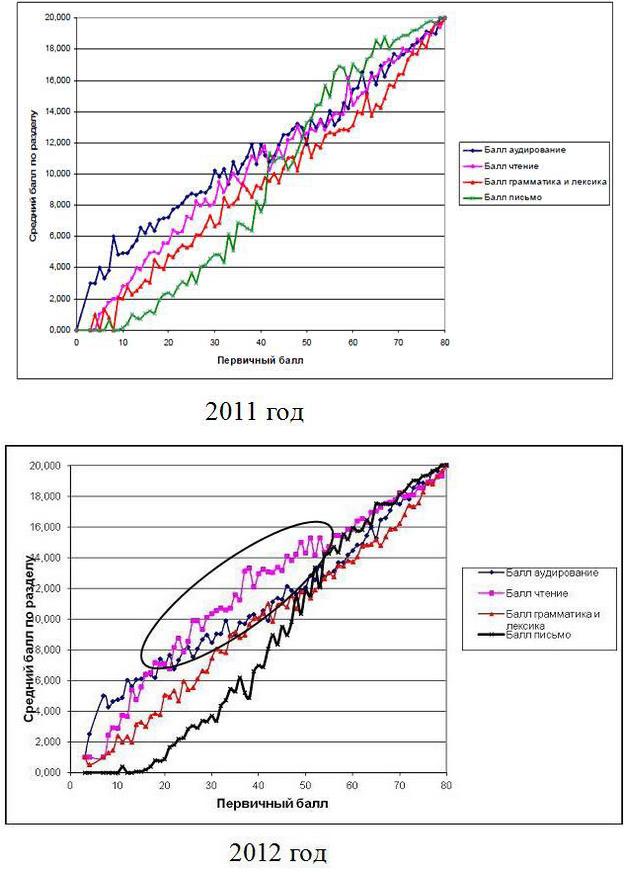

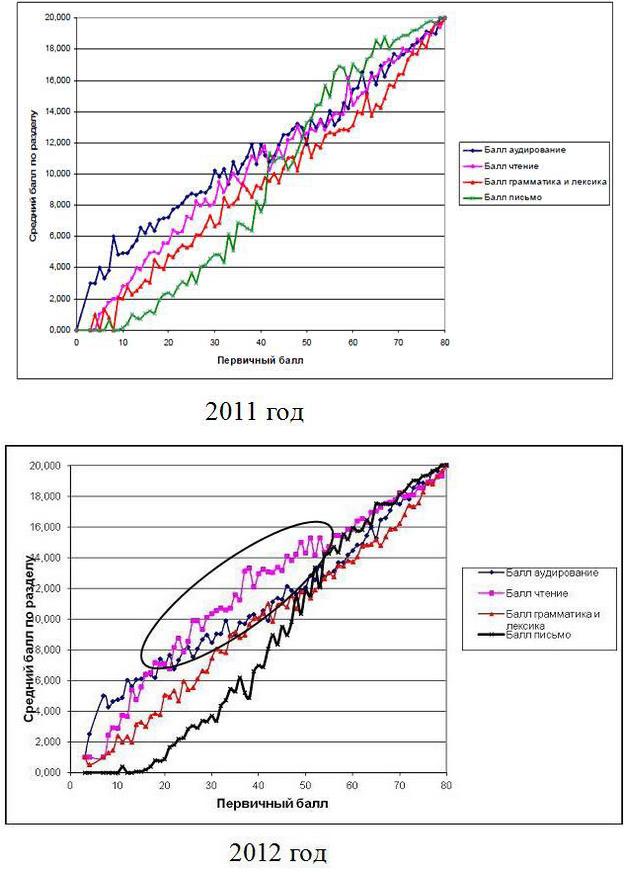

Стоило лишь поправить задание В2[29] и произошло чудо, которое, судя по реакции ФИПИ, требовало неприятных объяснений. Видимо поэтому ФИПИ предпочел не заметить его. В своем отчете он вскользь объяснил некоторые успехи «немцев» 10% ростом выполнения задания С2, относящегося к разделу «Письмо»[12, с. 10]. Между тем, из графиков ФИПИ (рис.12) следует, что основной вклад в повышение результата внес раздел «Чтение», к которому и относится задание В2. Именно здесь учащиеся со средней подготовкой (с первичным баллом от 20 до 60) чаще всего набирали баллы.

Рис. 12. Графики ФИПИ «Зависимость общего первичного балла от результата выполнения разных разделов экзамена (немецкий язык)»

|

Странно, что проверяя умение школьников читать информацию, представленную в различных знаковых схемах (график, таблица), ФИПИ не может прочесть графики в собственных отчетах. Неравноценные задания по иностранным языкам не применялись бы так долго, проведи ФИПИ своевременный анализ указанных расхождений. Свои ошибки институт исправил лишь после того, как о них уже заговорили с мест, в частности питерские эксперты[30].

К проблемам социальных эффектов ЕГЭ

Трудности анализа результатов ЕГЭ связаны также с тем обстоятельством, что специалистам практически ничего не известно об участниках испытаний. Именно поэтому они, как правило, не выходят за рамки изучения решаемости отдельных заданий. ФИПИ, например, сразу оговаривается, что социальные эффекты экзамена он не рассматривает по причине отсутствия контекстной информации. Сходные затруднения испытывают и аналитики на местах.

Вместе с тем попытки увязать достижения образовательных учреждений на ЕГЭ с другими показателями, характеризующими их деятельность, все же предпринимаются. В просмотренных нами отчетах они, к сожалению, носят несколько отвлеченный характер. Специалисты не чувствуют материала, а потому не объясняют причин статистических взаимозависимостей, а только констатируют их. Чаще всего исследователи обнаруживают корреляцию среднего балла школ с численностью учащихся в них. Рассмотрим только эту связь, поскольку она является причиной появления корреляции среднего балла с другими показателями школ: местом расположения, видом (обычная школа, школа с углубленным изучением отдельных предметов, гимназия, лицей), наполняемостью классов, обеспеченностью литературой, состоянием и разнообразием материально-технической базы и т.д.

На наш взгляд, причины зависимости результатов школ от численности учащихся связаны с социальными условиями функционирования и особенностями организации учебного процесса в учреждениях разной величины.

В городе существование статистической связи между численностью детей и средним баллом объясняется отбором и отсевом детей. С одной стороны, родители пытаются устроить ребенка в лучшее учебное заведение, как правило, крупное. С другой, сами школы при переводе учащихся из основного в старшее звено стараются отделаться от балласта слабых и ленивых. К тому же в условиях демографического спада (участники ЕГЭ — это дети демографической ямы) школы с хорошей репутацией имеют больше шансов успешно провести наборы и сохранить контингент, а потому и остаться крупными. И наоборот, школы, где образовательный процесс хромает, теряют воспитанников и мельчают. Здесь же следует учитывать, что гимназии и лицеи — это большие учреждения, где обычно подбирается и сильный состав преподавателей.

Другая причина — уровень доходов родителей, определяющий возможности выпускников получать дополнительную подготовку на курсах, с репетиторами и т.д. Состоятельные родители стараются устроить своих детей в учреждения повышенного уровня, как правило, крупные. Дети, получающие дополнительную подготовку к ЕГЭ, повышают не только свой результат, но и результаты своих школ.

На селе зависимости между итогами ЕГЭ и величиной образовательных учреждений мы уже не найдем. Сельские школы вынуждены обучать всех детей села и предварительного отбора они не ведут. К тому же, желая сохранить нагрузку и кадры, администрация пытается удерживать слабых учащихся до 11 класса, что снижает общешкольный результат.

Причины отставания сельских учреждений от городских, известны:

1) главная причина — особенности организации учебного процесса в небольших школах;

2) специфика комплектования малокомплектных школ педагогическими кадрами, как следствие причин 1 и 3;

3) слабый контингент учащихся как следствие социальных условий проживания в данной местности и причин 1 и 2.

Остановимся на первых двух причинах. Малые школы сел и городских поселков находятся, как правило, на территориях с пониженной транспортной доступностью и слабо развитой социальной инфраструктурой. Выпускники, оканчивающие такие школы, пытаются поступить в вузы, училища или просто перебраться в город. В силу сравнительно слабой подготовки они попадают, в основном, не в высшие, а в средние профессиональные учебные заведения, в т.ч. педагогические. Как результат сельская малая школа комплектуется, в основном, своими же выпускниками со средней профессиональной подготовкой. Городских выпускников на село не заманишь. Например, в Омской области в период с 2002 по 2007 год среди 2 тыс. молодых специалистов, прибывших на село, 85% составляли выходцы из местных

На что может рассчитывать выпускник педколлежа, возвращаясь в родную школу? Особенностью малокомплектных школ является отсутствие часов на полную ставку у значительной части учителей. В школах, где на каждой возрастной параллели имеется только один класс, насчитывается следующее число ставок: начальных классов — 4, русского языка и литературы — 2,5, иностранных языков — 1,1, математики — 1,9, истории, обществознания, экономики — 1,7, географии и экономической географии — 0,6, биологии, экологии, природоведения — 0,9, физики и астрономии — 0,8, химии — 0,6, изобразительного искусства и черчения — 0,3, музыки — 0,2, физкультуры и ОБЖ — 1, информатики — 0,3, труда — 0,8. Поэтому особенностью занятости здесь является широко распространенное совместительство, в том числе непрофильное. Попав в школу, выпускник педучилища зачастую вынужден вести предметы, которым он даже не обучался. По данным социологического опроса молодых специалистов, трудоустроенных в образовательных учреждениях сельских районов Омской области, около половины из них в той или иной мере обременены непрофильной нагрузкой (опрошены 300 молодых учителей, трудоустроенных в сельских школах в 2009–2011 годах), из-за чего свыше трети опрошенных лишь частично или поверхностно успевают готовиться к занятиям. Непрофильная занятость, особенно учителей естественно-математического и гуманитарного циклов, сопровождается большим объемом самостоятельной работы, т.к. необходимо обеспечить приемлемое качество уроков по предметам, где работник специалистом не является. Разнопредметная нагрузка становится причиной перегрузок, неудач, разочарований, появления желания покинуть школу. Поэтому среди молодых педагогов всегда фиксируется повышенная текучесть кадров.

В случае если молодой учитель устроится в соответствии с полученной специальностью, легкой жизни в малокомплектной школе он все равно не найдет. Даже имея однопредметную нагрузку, преподаватели основных дисциплин работают здесь в чрезвычайно тяжелых условиях. На ставке в 18 часов и при 6-дневной рабочей неделе они обязаны ежедневно готовиться к трем урокам по трем НОВЫМ темам, потому что в школе нет параллельных классов. Это 18 новых подготовок в неделю. К пройденному и знакомому материалу учитель может вернуться только через год, изучая его с детьми следующей возрастной категории. Если вспомнить требования к уроку, сразу станет ясно насколько проблематично обеспечить их в условиях этого конвейера. Сможет ли специалист со средним профессиональным образованием хорошо подготовить школьников к ЕГЭ в таких условиях?

Проблема комплектования сельских школ имеет еще один аспект. Подавляющее большинство молодых педагогов — девушки, одной из главных жизненных целей которых является создание семьи. Если молодая учительница, прибыв на село, сумеет здесь создать семью, то есть надежда, что в школе она останется. В противном случае велика вероятность увольнения, а на ее месте окажется следующий «кандидат на вылет».

Поиски социальных причин, влияющих на результаты ЕГЭ, сами по себе интересные, редко носят практический характер: обнаруженные факторы обычно не поддаются регулированию со стороны органов управления образованием. Гораздо продуктивнее представляется изучение условий, определяющих качество учебного процесса непосредственно в школах (вид учебника, система подвоза школьников, сменность занятий, профессионально-квалификационный состав преподавателей и т.д.). К сожалению, эти показатели в системе ведомственной статистики практически отсутствуют (см.[29]).

Сопутствующей проблемой является уровень специальной подготовки работников, анализирующих результаты ЕГЭ.

После окончания экзаменов РЦОИ всей страны подводят итоги. В основном результаты испытаний сводятся в статистические сборники, по объему очень внушительные. Между тем трудозатраты на их создание невелики. Все таблицы, которые можно встретить в региональных отчетах, легко делаются в программе Excel за два-три дня. При этом усилия составителей связаны не с обработкой данных, происходящей на современных ЭВМ мгновенно, а к оформлению результата (форматирование таблиц и графиков). Аналитику экзамена сотрудники РЦОИ, как правило, не пишут. Пишут ее преподаватели и методисты местных институтов повышения квалификации. Однако для РЦОИ это не оправдание. Экзамен закончен, а понимания того, что сделано, нет. Чем же занят персонал после экзамена?

Что касается Омской области, то здесь даже статистику грамотно свести не могут. Результаты по региону без комментариев и объяснений РИАЦ из года в год сваливает в огромные и пустые таблицы, предоставляя читателям самим ковыряться в цифрах, зачастую сомнительных и несопоставимых[31]. Так, омские сборники по математике в течение нескольких лет приводили данные о решаемости задач по спецификации 2004 года, в то время как контрольно-измерительные материалы постоянно менялись. «Творения» РИАЦ вводили в заблуждение не только омских учителей. Из них ошибки стали перекочевывать и в профессиональные издания[32]. Публикация недостоверных сведений по Омской области стала возможной по причине отсутствия анализа результатов ЕГЭ. Сотрудники омского аналитического центра не в силах не то что объяснить, но даже просто рассказать о них. Причины — низкая квалификация, неумение работать со специализированными статистическими и офисными программами, отсутствие навыков аналитики и, главное, интереса к экзамену. В 2011 году РИАЦ, имея в распоряжении пятнадцать аналитиков, семь методистов и уйму времени, по итогам ЕГЭ не написал ни строчки[33]. В 2012 году анализ по Омской области уместился в страничку безграмотного текста, обильно сдобренного рисунками и таблицами для наращивания объема. К примеру, работники РИАЦ пришли к странному выводу об улучшении в 2012 году качества подготовки омских школьников по литературе, в то время как средний балл по предмету снизился, а также увеличилась доля неудовлетворительных оценок. Практически весь сборник составляют таблицы. Допускаем, что составители приложили массу усилий. Но чтобы оценить их скажем, что для подготовки аналогичной статистики по региону за 2011 год автору (С.К.) понадобилось всего четыре часа.

Ошибки специалистов проявляются не только в интерпретации результатов ЕГЭ. Можно только посочувствовать, например, томскому гуманитарию, видимо не знающему базовых понятий статистики. Вместо того чтобы просто указать, что распределение имеет нормальный вид, он взялся его описывать:

«Похоже, что общая успеваемость учащихся по обществознанию стремится к усреднению, сужаясь по обоим краям: с одной стороны, уменьшается количество получающих низкие баллы, но в то же время сокращается количество набирающих наиболее высокие баллы»[22, с. 187].

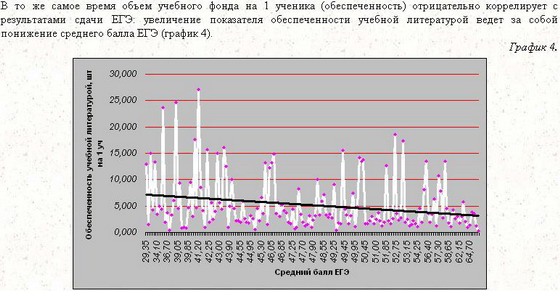

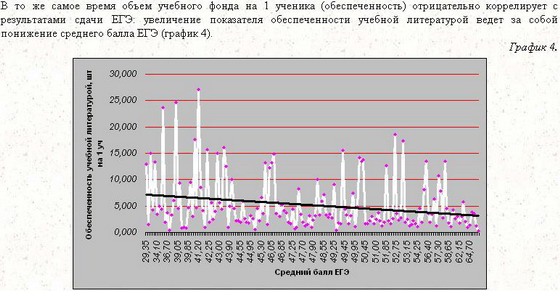

Приведем пример из форума ФИПИ (рис.13), где неназванные исследователи обнаружили, что обеспеченность учебной литературой влечет за собой понижение среднего балла ЕГЭ[34]. Связь между баллом и числом книг в школьной библиотеке действительно существует. Только является она вторичным проявлением другой связи: среднего балла и величины школы, чего авторы, видимо, не поняли. Вывод из обнаруженной зависимости следует сам собой: «Собрать все книги бы, да сжечь».

Рис. 13 Диаграмма из форума ФИПИ

|

Оригинальное ноу-хау демонстрируют омские специалисты по оценке качества образования. Они рассчитали средний балл по всем предметам, вычли из него прошлогодний результат и представили полученную разность как тенденцию состояния образования в регионе: «Общий средний балл по всем предметам в сравнении с 2011 годом снизился на 2,4 балла»[28, с. 5]. Остается загадкой, как рассчитывался этот «общий средний балл». Если как среднее арифметическое, то получается, что наравне с результатами по русскому языку и математике в подсчетах использовался балл по французскому и испанскому языкам, где в испытаниях участвовало по 2 человека. Если показатель является частным от деления суммы всех баллов на число человеко-экзаменов, то итог будет определяться результатами двух самых массовых испытаний (математика и русский язык), выдавать который за балл по остальным предметам было бы неверным.

Процитируем фрагмент из сборника РИАЦ:

«В 2011 г. в сельской местности по 8 из 13 предметов средний балл был выше, чем в населенных пунктах городского типа, а успеваемость по всем предметам была выше в селе. Таким образом, можно говорить, что по сравнению с 2011г. результаты ЕГЭ в 2012г. в населенных пунктах городского типа улучшились относительно сельской местности»[28, с. 6].

Уважаемые читатели! Вы что-нибудь поняли?

Еще пример:

«В 2012 г. так же как и в 2011 г. 3–4 экзамена сдает более 70% участников ЕГЭ. Однако наибольший общий средний балл по всем выбранным предметам показали выпускники текущего года, сдававшие пять предметов»[28, с. 5].

Да… В огороде бузина… Составители вряд ли сдали бы экзамен по русскому языку[35].

В другом сборнике, иллюстрируя результаты ЕГЭ по Омской области, РИАЦ публикует свыше десятка бестолковых графиков. Приведем один из них (рис. 14). Никого из авторов не смутило, что значение в 100 баллов (отличники) странным образом переместилось по шкале влево на второе место (рядом с двоечниками)[32, c. 160–167].

Рис. 14. График из отчета РИАЦ в 2013 году.

|

Невысокое качество публикуемых материалов по итогам ЕГЭ объясняется тем, что анализ проводят сотрудники, не имеющие не только специальной подготовки, но даже достаточного образования. Сразу вспоминается известное изречение: «Об образовании, как и о футболе, может судить любой».

Подведем итоги

1. Несмотря на десятилетнюю практику, серьезной проблемой ЕГЭ остается слабость аналитической работы. Последствия самые плачевные: неверная оценка уровня подготовки выпускников, бойкот экзаменов, неравные условия проведения испытаний (в частности среди учащихся, сдающих иностранные языки), неоправданные сложности при проверке работ и т.д. Отсутствие практики отправки региональных отчетов в ФИПИ, специалисты которого могли бы увидеть свои промахи и вовремя на них отреагировать, является причиной многих застарелых ошибок. А судя по унылому однообразию публикуемой ФИПИ аналитики, институт остро нуждается в свежем взгляде на экзамен со стороны.

К не менее печальным результатам приводит отсутствие анализа итогов ЕГЭ на местах. Именно по этой причине в Омской области местные руководители образованием проморгали саботаж обязательных испытаний.

2. Слабой стороной экзамена остается зависимость конструкции КИМов от технологии проверки работ: до сих пор широко распространены вопросы-угадайки и из контроля исчезают разделы математики, где невозможно дать ответ целым числом или конечной десятичной дробью. Делается это все ради того, чтобы работу можно было легко проверить. Но как? Силами программиста и бухгалтера, методиста и секретаря, на корявых бланках и немощной программой распознавания, под музыку и видео? Не слишком ли высокая цена? Ведь сложности верификации связаны не с большими объемами и сжатыми сроками исполнения работ, а с организацией труда и несовершенной программой распознавания. Пока штатные сотрудники РЦОИ будут получать деньги за верификацию, они будут стремиться освоить их собственными силами, следствием чего неизбежно станут штурмовщина, халтура и срывы сроков. Пока верификация будет вестись с помощью несовершенных программ, распознающих не смысл ответа, а буквы, его составляющие, проверка вопросов, где требуется записать что-либо иное кроме крестика, всегда будет требовать огромных трудозатрат.

3. Применяемая в настоящее время система перевода первичных баллов в тестовые крайне несправедлива. Высоко награждая за мизерные, достигаемые зачастую лишь гаданием ответов успехи, она несоразмерно строго наказывает учащихся за единичные ошибки. Это вносит значительные искажения в измерения учебных достижений: если первичные баллы дифференцируют школьников по уровню подготовки, то тестовые, наоборот, нивелируют их результаты. Стоит ли цепляться за непропорциональную шкалу начисления баллов, учитывая большой разброс вариантов по трудности? Межгодовая разница в сложности заданий, которую якобы сглаживает нелинейная шкала, вряд ли превысит этот разброс. Конечно специалистам, владеющим полной информацией, следует еще раз все посчитать. Но с несуразной системой перевода баллов в любом случае нужно что-то делать.

4. Одной из причин невысокого качества контрольно-измерительных материалов является стремление организаторов быстрее нарастить действующий банк заданий. Между тем применение экспериментально не испытанных, сырых и сомнительных задач вредит измерениям больше, чем использование пусть ограниченного, но проверенного их набора. Зачастую достижения выпускников зависят не столько от сложности материала, сколько от корректности инструмента контроля. Результаты ЕГЭ уже во многом запрограммированы технологией проверки работ и корректностью КИМов, внешняя экспертиза которых крайне затруднена их излишней закрытостью. По итогам испытаний специалистам оставлена возможность обсуждать лишь убогий демовариант, не изменяемый в некоторых дисциплинах годами. Закрытость КИМов после окончания испытаний не позволяет своевременно выявлять и устранять ошибки и консервирует их, что оборачивается против экзамена и его участников.

5. Проблемой организации ЕГЭ является низкая эффективность центров обработки информации как следствие сезонности работ[36]. Передача им задач по сбору ведомственной статистики остроты вопроса не снижает. Оптимальный вариант функционирования РЦОИ — это деятельность в качестве структурных подразделений институтов повышения квалификации работников образования. В рамках института легче решаются вопросы загруженности работников в межэкзаменационный период. При нехватке людей всегда есть возможность привлечь дополнительно штатных преподавателей. Одновременно специалисты профильных кафедр будут обладать полной информацией об экзамене и могут давать квалифицированный анализ результатов испытаний.

Предложения

Что можно предложить в условиях, когда аттестация выпускников школ в форме ЕГЭ законодательно закреплена? — Только лишь меры, направленные на ее совершенствование:

1. Полностью открыть Федеральный банк тестовых заданий. Контрольно-измерительные материалы накануне экзамена должны формироваться из него случайным образом отдельно для каждого региона.

2. Перейти на линейную шкалу перевода первичных баллов в тестовые.

3. Усовершенствовать инструментарий: убрать лишние клетки в бланке ответов и разрядить остальные, отдельно печатать бланки для иностранных языков (три альтернативы).

4. Изменить способ верификации: перейти от проверки знаков к проверке смысла ответа. Необходимы специализированные “интеллектуальные” программы распознавания ответов отдельно для каждой из дисциплин, использующих свою символику записи. По мере решения этой проблемы следует последовательно отказываться от закрытых вопросов. Уже сейчас это можно сделать в КИМах по физике и информатике.

5. Регламентировать верификацию:

станции верификации не должны иметь иного программного обеспечения кроме программы верификации, должны быть отключены от Интернета и мультимедийных средств;

исключить участие в проверке работ случайных людей: список привлекаемых к верификации лиц должен утверждаться приказом руководителя областного органа управления образованием;

работа должна быть организована по сменам (в две, три, четыре), но не более 6 часов в смену, сотрудники РЦОИ должны выполнять обязанности старшего верификатора в сменах, также не более 6 часов;

верификацию проводить в отдельно отведенных для этого помещениях;

запретить штатным работникам РЦОИ получать деньги за верификацию (верифицируют они в рабочее время, за что и получают зарплату).

6. Перевести РЦОИ в подчинение местных институтов повышения квалификации работников образования или аналогичных им структур. Ввести в обязательный функционал анализ результатов ЕГЭ (а не простой свод статистики). Аналитический отчет по региону выставлять сайт органа управления образованием субъекта Федерации за подписью его руководителя, а также направлять в ФИПИ. Возможно, ФИПИ следует организовать конкурс отчетов, которые позволили бы тиражировать по стране опыт успешных регионов.

7. ФИПИ обеспечить методически и информационно проведение анализа результатов ЕГЭ на местах. Для корректных межрегиональных сопоставлений разработать типологию регионов со сходными условиями функционирования образовательных учреждений. Ежегодно публиковать итоги испытаний по субъектам Федерации и (или) федеральным округам с необходимыми пояснениями о пределах допустимости сравнения результатов. Разработать для регионов алгоритм изучения итогов ЕГЭ. Провести обучение специалистов на местах приемам статистического анализа.

2013 г.

По этой теме читайте также:

Примечания

Литература

1. Результаты Единого государственного экзамена (май-июнь 2006 года) Аналитический отчет, Москва, 2006.

2. Аналитический отчет ФИПИ 2007г., Москва, URL: http://www.fipi.ru/view/ sections/138/docs/318.html.

3. Результаты Единого государственного экзамена (май-июнь 2008 года), Москва, 2008, URL: http://www.fipi.ru/view/sections/138/docs/401.html.

4. Результаты Единого государственного экзамена (май-июнь 2009 года), Москва, 2009, URL: http://www.fipi.ru/view/sections/138/docs/478.html.

5. Итоговый аналитический отчет о результатах проведения ЕГЭ в 2010 году (май-июнь 2010 года), Москва, 2010, раздел “Обществознание”, URL: http://www.fipi.ru/binaries/ 1069/OB_11_ 2010.pdf.

6. Итоговый аналитический отчет о результатах проведения ЕГЭ в 2010 году (май-июнь 2010 года), Москва, 2010, раздел 1, http://www.fipi.ru/binaries/1085/1_razdel_11_ 21092010.pdf.

7. Итоговый аналитический отчет о результатах проведения ЕГЭ в 2010 году (май-июнь 2010 года), Москва, раздел “Математика”, URL: http://www.fipi.ru/binaries/ 1084/mat11.pdf.

8. Итоговый аналитический отчет о результатах проведения ЕГЭ в 2010 году, Москва, 2010, раздел “Физика”, URL: http://www.fipi.ru/binaries/1070/FI_11_2010.pdf.

9. Основные результаты ЕГЭ 2010г., URL: http://www.fipi.ru/binaries/1085/1_razdel_ 11_21092010.pdf.

10. Итоговый аналитический отчет о результатах Единого государственного экзамена 2011 года, Москва, 2011, раздел 1, http://www.fipi.ru/binaries/1189/1osnrez2011.pdf.

11. Итоговый аналитический отчет о результатах Единого государственного экзамена 2011 года, Москва, 2011раздел 2.7, http://www.fipi.ru/binaries/1196/2.7.obs–11–11.pdf.

12. Итоговый аналитический отчет о результатах ЕГЭ, Москва, 2012, раздел.2.10, URL: http://fipi.ru/view/sections/138/docs/624.html.

13. Анализ результатов Единого государственного экзамена в Московской области в 2008 году, Сборник информационно-методических материалов, Москва, 2008, URL: http://rcoi.net/statistika-i-analitika/105.html.

14. Анализ результатов Единого государственного экзамена в Московской области в 2009 году, Сборник методических материалов, Москва, 2009, URL: http://rcoi.net/statistika-i-analitika/237-analitika–2009.html.